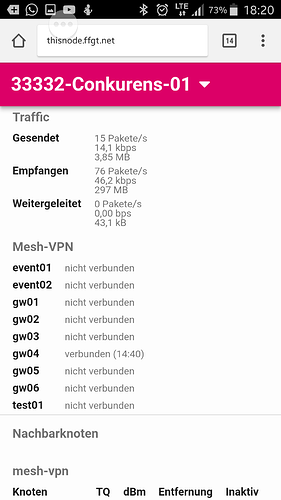

fastd arbeitet ähnlich wie gpg oder ssh mit öffentlichen und privaten Schlüsseln. Jedes Gateway hat ein anderes Schlüsselpaar. Daher haben die 4 GWs hinter gw04[-neu].4830.org alle den Schlüssel für gw04 laut site.conf. Und somit ist es mit Umbiegen des FQDN nicht getan, die GWs müßten umkonfiguriert werden auf die Parameter der Zielgateways.

Hinzu kommt: das Setup ist, mit dem Wissen von heute, nicht zweckdienlich: es sind zwei Gruppen von GWs definiert, zu jeder Gruppe soll genau eine Verbindung gehalten werden. Heißt: zu jedem Knoten hätten wir dann in batman im optimalen Fall zwei Pfade, die Anzahl der Routen verdoppelt sich also. Wir hatten vor Jahren schon von 2 auf 1 Verbindung ins Mesh umgestellt, weil es a) viel Overhead mit sich brachte und b) der Failover nicht wirklich funktionierte. Ich habe daher die DNS-Einträge für die »Event-GWs« gerade deaktiviert, TTL ist 1h, mal gucken, ob das was bringt. Es wird nun wieder das Log vollgemüllt (das zu vermeiden war der Grund vor ein paar Monden, da Dummy-Einträge zu machen), aber hoffentlich erkennt fastd, daß mit der Gruppe kein Blumentopf zu holen ist (da kein FQDN aufgelöst werden kann).

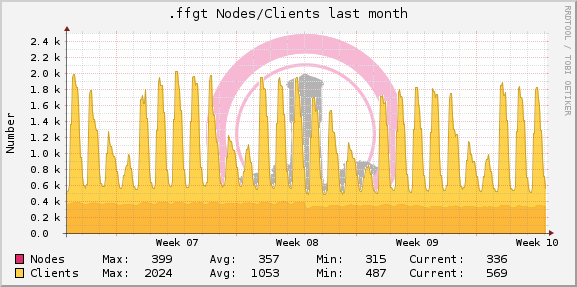

Sollte sich die Situation nicht verbessern, würde ich als nächstes die Anzahl der GWs wieder verringern, sodaß hinter jedem FQDN nur noch 1 GW liegt. Die Performance im Netz wird dann aber wieder unterirdisch sein, da die 4 fastd-Prozesse die ~400 Knoten tagsüber nicht bedienen können. Es müßte dann schnell eine aktualisierte FW hinterhergeschoben werden, die für jedes GW 1 FQDN hat.

Nachtrag: Sinn der »Event«-Gruppe war es, bei bestimmten »Events« einfach Knoten z. B. an eine privates Netz klemmen zu können, in denen ein lokales GW werkelt. Das hat sich aber alles überlebt, die Crux an fastd ist seine Userspace-Existenz, selbst von einer Gluon-VM im RZ, die per virtiuellem Kabel über fastd mit einem unserer GWs kommuniziert, sind keine 100 MBit/sec drin:

Gluon-VM:

Mem: 19660K used, 883916K free, 108K shrd, 764K buff, 5224K cached

CPU: 12% usr 25% sys 0% nic 22% idle 0% io 0% irq 37% sirq

Load average: 0.33 0.10 0.03 3/48 26299

PID PPID USER STAT VSZ %VSZ %CPU COMMAND

1713 1 root R 2996 0% 74% /usr/bin/fastd --config - --daemon --

Speedtest hinter der Gluon-VM:

root@33334-Wardialer:~# speedtest

Retrieving speedtest.net configuration...

Retrieving speedtest.net server list...

Testing from PlusServer GmbH (192.251.226.69)...

Selecting best server based on latency...

Hosted by KamaTera INC (Amsterdam) [2.18 km]: 17.681 ms

Testing download speed........................................

Download: 87.43 Mbit/s

Testing upload speed..................................................

Upload: 74.20 Mbit/s

root@33334-Wardialer:~#

Man könnte meinen, jedes MBit/sec braucht 1% CPU … Und das ist nur 1 Client hinter dem virtuellen Knoten. Das tote Pferd hier ist fastd und es ist Zeit, abzusteigen.